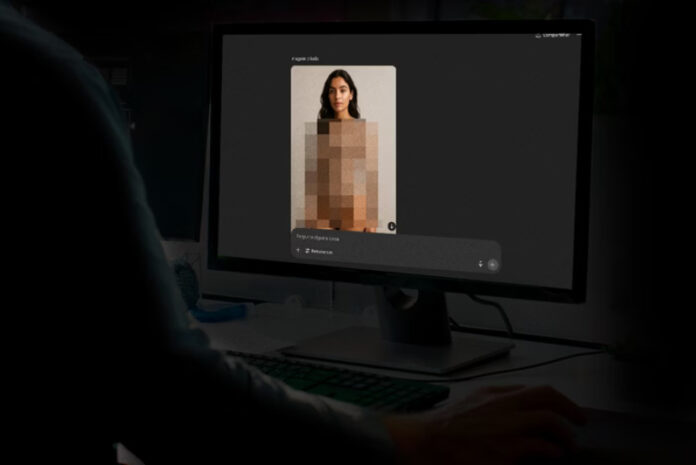

A revolução tecnológica impulsionada pela inteligência artificial (IA) tem gerado inovações extraordinárias — mas também traz riscos reais e cada vez mais próximos. Um caso recente em Belo Horizonte (MG) expôs de forma alarmante como ferramentas de IA podem ser usadas para a violação da dignidade humana, especialmente de adolescentes. Pelo menos 17 alunas do Colégio Santa Maria denunciaram ter tido suas imagens manipuladas digitalmente para compor material pornográfico falso.

As vítimas, estudantes do ensino médio, relataram que suas fotos — muitas vezes retiradas de redes sociais — foram usadas para gerar conteúdos explícitos com a ajuda de IA, no estilo conhecido como deepfake. Essas imagens falsas, vinculadas a seus nomes, circularam entre estudantes em grupos no WhatsApp e Telegram. Há suspeitas, inclusive, de que o material teria sido comercializado por um aluno da própria escola.

O impacto do caso e a mobilização jurídica

O caso ganhou visibilidade por meio da influenciadora Ive Moreira, de 21 anos, que divulgou as denúncias no TikTok. A repercussão trouxe à tona a angústia de meninas entre 12 e 17 anos, expostas a uma forma cruel de violência digital.

Diante da gravidade, o tema chegou ao Congresso Nacional. A Câmara dos Deputados aprovou um projeto de lei que tipifica a manipulação digital de nudez e cenas íntimas falsas como crime no Código Penal. Se também for aprovado pelo Senado, o responsável por esse tipo de conduta poderá pegar de 2 a 6 anos de prisão e multa — com agravantes se a vítima for mulher, criança, adolescente, idosa ou pessoa com deficiência. O uso massivo de redes sociais para disseminação do material pode dobrar a pena.

Orientações para vítimas e cuidados preventivos

Segundo a advogada Jéssica Marques, especialista em direito penal digital, a principal recomendação para vítimas de deepfake é reunir o máximo de provas possível. Isso inclui capturas de tela, links dos conteúdos e informações de quem teve acesso. “Se a imagem foi retirada de uma rede social, é fundamental registrar quem visualizou a publicação e reunir tudo em um dossiê que ajude a identificar o autor”, explica.

Ela também orienta a restringir o compartilhamento de fotos e vídeos nas redes e evitar chamadas de vídeo com desconhecidos, já que o conteúdo pode ser gravado e manipulado. Caso haja vazamento, é essencial notificar imediatamente a plataforma onde o material está hospedado e registrar boletim de ocorrência em uma delegacia especializada em crimes cibernéticos.

Google responde sobre uso indevido de IA

Com o avanço acelerado das tecnologias de geração de imagem, como o Veo 3 — ferramenta de IA lançada pelo Google que cria vídeos realistas com som e diálogos — cresce também o risco de uso indevido para fins como pornografia falsa.

Em resposta, o Google afirmou que suas políticas proíbem expressamente o uso de suas ferramentas para criar conteúdos sexualmente explícitos, violentos, discriminatórios ou enganosos. A empresa também destacou o uso da tecnologia SynthID, que insere marcas d’água invisíveis em todos os conteúdos gerados por IA, além de aplicar selos visíveis em vídeos — com exceção dos produzidos na versão Ultra da ferramenta Flow.

Lacunas legais e o desafio da proteção de dados

Apesar dos esforços legislativos, o Brasil ainda enfrenta sérios obstáculos no enfrentamento desse tipo de crime. De acordo com o professor Alexandre Veronese, da Universidade de Brasília (UnB), há deficiências na legislação penal e processual para lidar com delitos digitais complexos, como os deepfakes.

Ele aponta ainda um problema jurídico importante: a Lei Geral de Proteção de Dados (LGPD) não se aplica a investigações criminais, segurança pública e defesa nacional — uma exceção que, segundo ele, gera insegurança jurídica. “A Constituição assegura a proteção de dados como direito fundamental. O Brasil precisa, com urgência, compatibilizar suas normas com esse princípio”, afirma Veronese, citando decisões recentes do STF que reforçam a necessidade de revisão.

IA: ferramenta poderosa que também pode ser arma

O professor alerta que a mesma IA que automatiza tarefas e otimiza serviços pode, nas mãos erradas, servir à disseminação de crimes digitais — como falsificação de identidade, chantagem, fraudes e pornografia não consentida. Ele defende que o país crie agravantes penais e indenizações mais severas para crimes cometidos com auxílio de IA. No entanto, adverte que proibir ou restringir amplamente o uso da tecnologia pode ser ineficaz.

“Não se trata de demonizar a IA, mas de entender seus riscos e regular seu uso com critérios claros. Criar medo em torno da ferramenta não resolve o problema — precisamos de leis inteligentes e de educação digital”, conclui.

Reflexão final

O caso das alunas do Colégio Santa Maria é mais do que uma denúncia isolada: é um sinal claro de que o país precisa agir. A manipulação de imagens por IA para fins abusivos não é apenas uma questão técnica, mas ética, jurídica e social. E enquanto a tecnologia avança, é imperativo que o direito acompanhe — garantindo às vítimas o que a tecnologia sozinha não pode oferecer: justiça.

Com informações de Metrópoles